Cluster Proxmox, Live Migration с использованием iSCSI NAS

Доброго времени коллеги. Для меня очень интересная тема визуализации. Хочу

Доброго времени коллеги. Для меня очень интересная тема визуализации. Хочу Настройка и эксплуатации возможности Live Migration виртуальных машин в Proxmox VE с использованием iSCSI NAS.

Качаем downloads, ставим.

1. aptitude update && aptitude full-upgrade

2. Выравниваем время на обоих серверах

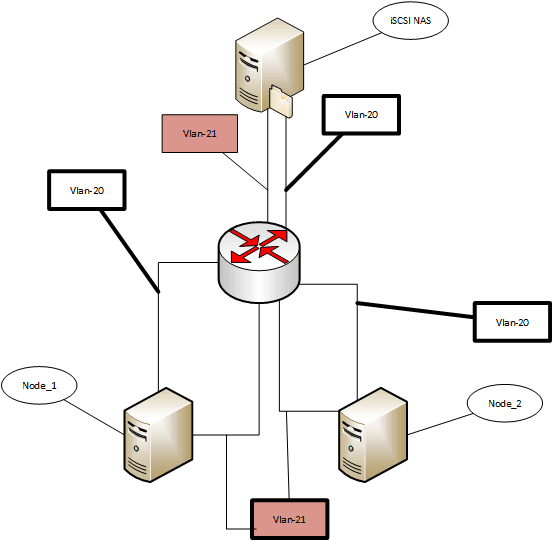

3. На свиче настраиваем vlan.В vlan 21 у нас идет сеть 10.0.1.0/24 (Private network), а в vlan 20 192.168.0.0/24 (Public network) рулит сетями cisco catalist

Далее выполняется только на одной ноде и только один раз. Заходим на 1 ноду (10.0.1.1) и создаем кластер:

pvecm create name-clusterДалее заходим на остальные ноды и добавляем остальные имеющиеся ноды 2 (10.0.1.2) и т.д. добавляем их в кластер:

pvecm add 10.0.1.1Далее подключаемся по https к любой из нод 192.168.0.1

Проходим авторизацию. видим наши ноды

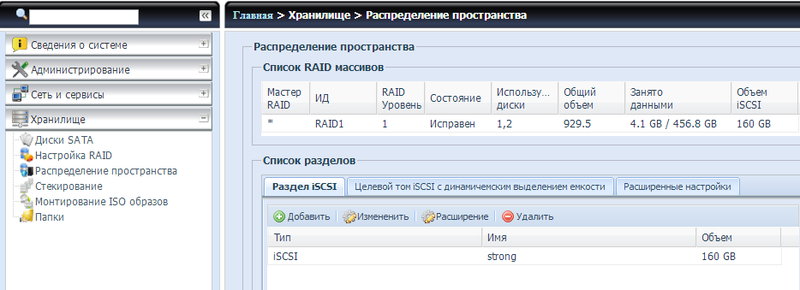

Конфигурируем iSCSI target:

После создания раздела на NAS

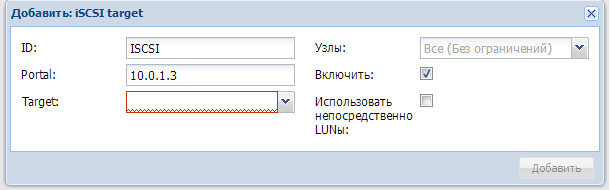

подключаем его в proxmox Дата центр, хранилища, добавить: ISCSI target:

в пункте Portal: указываем IP адрес файлового хранилища. далее разворачиваем список target и видим созданный ранее hdd:

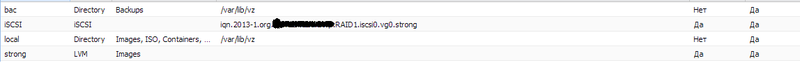

Далее создаем LVM группу. Дата центр, хранилища, LVM Group:

После успешного подключение в разделе хранилища наблюдаем успешно подключенный диск:

Создание VM

Теперь можно приступать к созданию первой VM в настройках жесткого диска при создании VM указываем в device: VIRTO и выбираем хранилище созданное ранее, и соответственно размер HDD.

По завершению инсталляции на VM нашей OS можно выделить VM и выбрать пункт «Миграция» выбрать соответствующую ноду установить галочку на online выполнить миграцию.

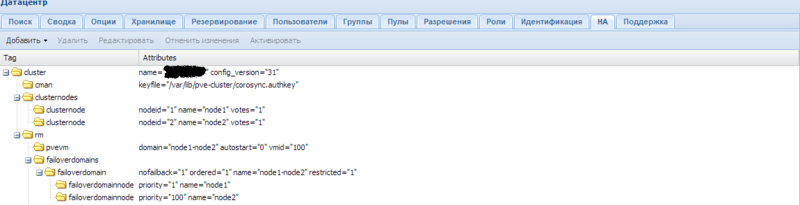

High Availability

вот с High Availability у меня получилась сложность пришлось привести cluster.conf (/etc/pve/cluster.conf) к такому виду (важно при редактирование cluster.conf изменять версию конфига на шаг вперед)

<code class="bash"><?xml version="1.0"?>

<cluster config_version="31" name="name-cluster">

<cman keyfile="/var/lib/pve-cluster/corosync.authkey"/>

<clusternodes>

<clusternode name="node1" nodeid="1" votes="1"/>

<clusternode name="node2" nodeid="2" votes="1"/>

</clusternodes>

<rm>

<pvevm autostart="0" domain="node1-node2" vmid="100"/>

<failoverdomains>

<failoverdomain name="node1-node2" nofailback="1" ordered="1" restricted="1$

<failoverdomainnode name="node1" priority="1"/>

<failoverdomainnode name="node2" priority="100"/>

</failoverdomain>

</failoverdomains>

</cluster>

</code>Кого интересует нагрузка в режиме почти неактивной OS вот скрин

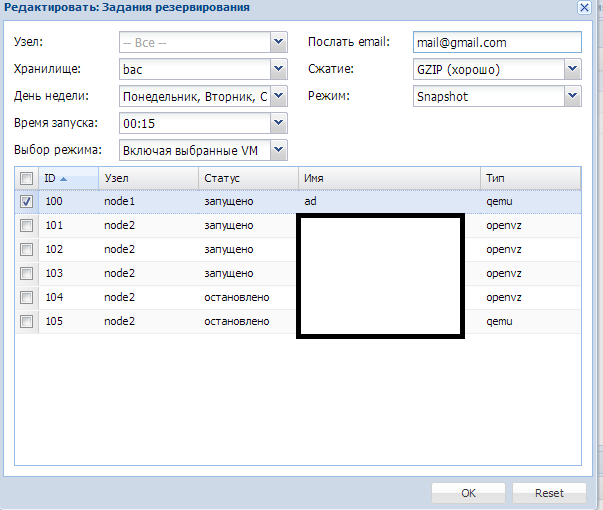

backup

Можно выполнять в ручную или же можно задать время и дни недели с указанием пути для хранения архива, с указанием почтового ящика для уведомления о состоянии бэкапа, успешно ли он прошел или же была ошибка.

Отчет о выполненной работе

На почту падает вот такой отчет. (заметьте файл бэкапа перезаписываеться)

<habracut/>

VMID NAME STATUS TIME SIZE FILENAME

100 ad OK 00:44:07 9.76GB /var/lib/vz/dump/vzdump-qemu-100-2013_02_12-00_15_01.tar.gz

TOTAL 00:44:07 9.76GB

Detailed backup logs:

vzdump 100 --quiet 1 --mailto mail@gmail.com --mode snapshot --compress gzip --storage bac

100: Feb 12 00:15:01 INFO: Starting Backup of VM 100 (qemu)

100: Feb 12 00:15:01 INFO: status = running

100: Feb 12 00:15:03 INFO: backup mode: snapshot

100: Feb 12 00:15:03 INFO: ionice priority: 7

100: Feb 12 00:15:03 INFO: Found duplicate PV 2tCjPP4z55dDHBGuSUmdp1c2ZIHwlx00: using /dev/sdc not /dev/sdb

100: Feb 12 00:15:04 INFO: Logical volume «vzsnap-node1-0» created

100: Feb 12 00:15:05 INFO: creating archive '/var/lib/vz/dump/vzdump-qemu-100-2013_02_12-00_15_01.tar.gz'

100: Feb 12 00:15:05 INFO: adding '/var/lib/vz/dump/vzdump-qemu-100-2013_02_12-00_15_01.tmp/qemu-server.conf' to archive ('qemu-server.conf')

100: Feb 12 00:15:05 INFO: adding '/dev/pv/vzsnap-node1-0' to archive ('vm-disk-sata0.raw')

100: Feb 12 00:59:05 INFO: Total bytes written: 80530639360 (29.09 MiB/s)

100: Feb 12 00:59:05 INFO: archive file size: 9.76GB

100: Feb 12 00:59:05 INFO: delete old backup '/var/lib/vz/dump/vzdump-qemu-100-2013_02_11-00_15_01.tar.gz'

100: Feb 12 00:59:08 INFO: Finished Backup of VM 100 (00:44:07)

Негатив даже очень приветствуется.

Следующий опыт, построение Failover cluster на windows 2012, а так же Failover cluster MS SQL 2012

0 комментариев